Αυτόν τον µήνα, η OpenAI, η εταιρεία του δηµοφιλούς ChatGPT, χάρισε στο διαδίκτυο µια τεχνολογία για την οποία οι περισσότεροι µάλλον δεν είµαστε ακόµη έτοιµοι.

Η εταιρεία κυκλοφόρησε µια εφαρµογή µε το όνοµα Sora, η οποία επιτρέπει στους χρήστες να δηµιουργούν στη στιγµή ρεαλιστικά βίντεο µε Τεχνητή Νοηµοσύνη, απλώς πληκτρολογώντας µια σύντοµη περιγραφή -για παράδειγµα: «Πλάνα από κάµερα της αστυνοµίας που δείχνουν έναν σκύλο να συλλαµβάνεται επειδή έκλεψε rib-eye από το σούπερ µάρκετ».

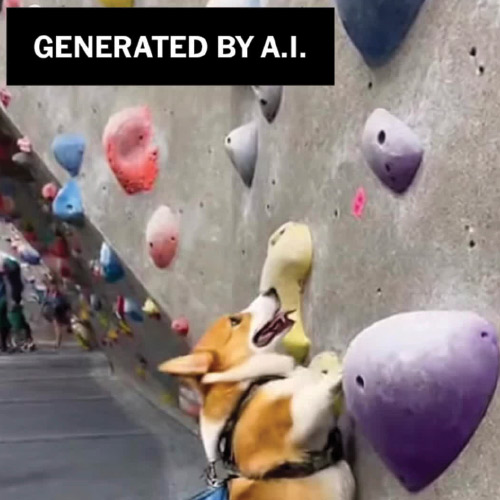

Η εφαρµογή Sora, διαθέσιµη δωρεάν για iPhone, είναι ταυτόχρονα διασκεδαστική και ανησυχητική. Από την κυκλοφορία της, πολλοί από τους πρώτους χρήστες έχουν αναρτήσει βίντεο για διασκέδαση, όπως ψεύτικα πλάνα κινητού µε ένα ρακούν µέσα σε αεροπλάνο ή αγώνες πάλης µεταξύ διασήµων του Χόλιγουντ σε στυλ ιαπωνικού anime. Εγώ προσωπικά διασκέδασα φτιάχνοντας βίντεο µε µια γάτα που ανεβαίνει στον παράδεισο και µε έναν σκύλο που σκαρφαλώνει σε βράχους µιας προπονητικής πίστας αναρρίχησης.

Άλλοι, όµως, χρησιµοποίησαν το εργαλείο για πιο δόλιους σκοπούς, όπως η διάδοση παραπληροφόρησης, συµπεριλαµβανοµένου ψεύτικου υλικού καµερών ασφαλείας από εγκλήµατα που δεν συνέβησαν ποτέ.

Η άφιξη του Sora, µαζί µε παρόµοιες AI εφαρµογές που κυκλοφόρησαν φέτος η Meta και η Google, έχει µεγάλες επιπτώσεις. Αυτή η τεχνολογία µπορεί να σηµατοδοτεί το τέλος της «οπτικής αλήθειας» -της ιδέας ότι το βίντεο αποτελεί µια αντικειµενική καταγραφή της πραγµατικότητας- όπως την ξέρουµε. Στο εξής, η κοινωνία συνολικά θα πρέπει να αντιµετωπίζει τα βίντεο µε τον ίδιο σκεπτικισµό που ήδη δείχνει απέναντι στις λέξεις.

Κατά το παρελθόν, οι χρήστες του διαδικτύου είχαν µεγαλύτερη εµπιστοσύνη ότι οι εικόνες είναι αληθινές («να δω φωτογραφία, αλλιώς δεν συνέβη ποτέ!»). Όταν οι φωτογραφίες έγινε εύκολο να παραποιηθούν, τα βίντεο -τα οποία απαιτούσαν πολύ µεγαλύτερη ικανότητα για να αλλοιωθούν- θεωρούνταν τυπικό τεκµήριο αυθεντικότητας. Τώρα αυτό δεν ισχύει.

«Ο εγκέφαλός µας είναι προγραµµατισµένος να πιστεύει αυτό που βλέπει· όµως πλέον πρέπει να µάθουµε να σταµατάµε και να σκεφτόµαστε αν ένα βίντεο -ή οποιοδήποτε άλλο µέσο- δείχνει κάτι που πραγµατικά συνέβη στον κόσµο», λέει ο Ren Ng, καθηγητής πληροφορικής στο Πανεπιστήµιο της Καλιφόρνια στο Μπέρκλεϊ, ο οποίος διδάσκει υπολογιστική φωτογραφία.

Το Sora, που έγινε η πιο δηµοφιλής δωρεάν εφαρµογή στο App Store της Apple, προκάλεσε αναστάτωση στο Χόλιγουντ. Τα στούντιο εκφράζουν την ανησυχία τους ότι τα βίντεο που δηµιουργούνται µε την εφαρµογή έχουν ήδη παραβιάσει πνευµατικά δικαιώµατα από ταινίες, σειρές και χαρακτήρες.

Ο διευθύνων σύµβουλος της OpenAI, Sam Altman, δήλωσε ότι η εταιρεία συλλέγει σχόλια και παρατηρήσεις, και ότι σύντοµα θα επιτρέψει στους κατόχους πνευµατικών δικαιωµάτων να ελέγχουν τη χρήση των έργων τους και να αποκοµίζουν έσοδα από την πλατφόρµα.

Οι New York Times έχουν καταθέσει αγωγή κατά των OpenAI και Microsoft, υποστηρίζοντας ότι υπάρχει παράβαση σε ό,τι αφορά την πνευµατική ιδιοκτησία ειδησεογραφικού περιεχοµένου του Μέσου, το οποίο χρησιµοποιήθηκε για εκπαίδευση συστηµάτων ΑΙ. Οι δύο εταιρείες αρνούνται τις κατηγορίες.

Πώς όµως λειτουργεί το Sora και τι σηµαίνει αυτό για τους καταναλωτές; Ιδού τι πρέπει να γνωρίζετε.

Εικόνα από βίντεο που δημιουργήθηκε με το Sora, ύστερα από προτροπή του δημοσιογράφου των New York Times, Brian X. Chen: ένας σκύλος σκαρφαλώνει σε βράχους μέσα σε γυμναστήριο αναρρίχησης. (via The New York Times)

Πώς χρησιµοποιούν οι άνθρωποι το Sora;

Αν και οποιοσδήποτε µπορεί να κατεβάσει την εφαρµογή δωρεάν, η υπηρεσία λειτουργεί προς το παρόν µόνο µε πρόσκληση -δηλαδή οι χρήστες µπορούν να χρησιµοποιήσουν την εφαρµογή µόνο αν έχουν κωδικό πρόσκλησης από άλλον χρήστη για να ενεργοποιήσουν τον λογαριασµό τους. Πολλοί µοιράζονται τέτοιους κωδικούς σε πλατφόρµες όπως Reddit και Discord.

Αφού κάποιος εγγραφεί, αυτό που βλέπει είναι µια εφαρµογή που µοιάζει παρόµοια µε εφαρµογές σύντοµων βίντεο, όπως το TikTok και το Instagram Reels. Οι χρήστες µπορούν να δηµιουργήσουν ένα βίντεο απλώς πληκτρολογώντας µια οδηγία -π.χ. «µια µάχη ανάµεσα στον Biggie και τον Tupac στο στυλ του ιαπωνικού anime “Demon Slayer”».

Πριν ο Altman ανακοινώσει ότι οι κάτοχοι πνευµατικών δικαιωµάτων θα αποκτήσουν µεγαλύτερο έλεγχο, η OpenAI έλεγε πως οι χρήστες που δεν θέλουν να χρησιµοποιείται η εικόνα ή το brand τους πρέπει να το δηλώσουν -κατάσταση που οδηγούσε σε πειραµατισµούς ακόµη και µε εικόνες ανθρώπων που δεν ζουν πια.

Οι χρήστες µπορούν επίσης να ανεβάσουν µια πραγµατική φωτογραφία και να ζητήσουν από την εφαρµογή να δηµιουργήσει ένα βίντεο µε βάση αυτήν. Η διαδικασία διαρκεί περίπου ένα λεπτό και στη συνέχεια µπορούν να δηµοσιεύσουν το βίντεο στο feed της εφαρµογής, να το κατεβάσουν και να το στείλουν σε φίλους τους ή να το αναρτήσουν σε άλλες εφαρµογές, όπως το TikTok και το Instagram.

Με το που κυκλοφόρησε η εφαρµογή Sora δεν άργησε να ξεχωρίσει, καθώς τα βίντεο που παράγει δείχνουν πολύ πιο ρεαλιστικά σε σχέση µε τα βίντεο αντίστοιχων εφαρµογών όπως το Veo 3 της Google -ένα εργαλείο που φτιάχτηκε ως µέρος του chatbot Gemini- ή το Vibe, το οποίο είναι µέρος της εφαρµογής Meta ΑΙ.

Σε μια φωτογραφία από βίντεο που δημιούργησε με το Sora της OpenAI ο δημοσιογράφος των New York Times, Brian X. Chen, φαίνεται μια γάτα να ανυψώνεται προς τον παράδεισο. (via The New York Times)

Τι σηµαίνει αυτό για µένα;

Το αποτέλεσµα είναι ότι οποιοδήποτε βίντεο βλέπεις σήµερα σε εφαρµογές όπως TikTok, Instagram Reels, YouTube Shorts ή Snapchat έχει µεγάλη πιθανότητα να είναι ψεύτικο.

Η εφαρµογή Sora σηµατοδοτεί ένα σηµείο καµπής στην εποχή του AI πλαστού περιεχοµένου. Οι καταναλωτές πρέπει να περιµένουν ότι πολύ σύντοµα θα εµφανιστούν µιµητές -και κακόβουλοι- που θα προσφέρουν εργαλεία παραγωγής βίντεο χωρίς περιορισµούς. «Κανείς δεν θα δέχεται πλέον ένα βίντεο ως απόδειξη για οτιδήποτε», λέει ο Lucas Hansen, ιδρυτής της CivAI, µιας ΜΚΟ που εκπαιδεύει το κοινό σε ό,τι αφορά τις δυνατότητες της Τεχνητής Νοηµοσύνης.

Τι πρέπει να προσέχω;

Η OpenAI έχει θεσπίσει περιορισµούς ώστε να αποτρέψει τη χρήση του Sora για δηµιουργία βίντεο µε σεξουαλικό περιεχόµενο, µε παραπλανητικές ιατρικές πληροφορίες ή µε τροµοκρατική προπαγάνδα.

Ωστόσο, µετά από µία ώρα δοκιµών της εφαρµογής, δηµιούργησα κάποια βίντεο που µπορεί να είναι ανησυχητικά:

- Ψεύτικα πλάνα από κάµερες αυτοκινήτων (dashcam) που θα µπορούσαν να χρησιµοποιηθούν για ασφαλιστική απάτη -ζήτησα από την εφαρµογή να δηµιουργήσει βίντεο µε ένα Toyota Prius που το χτυπάει ένα µεγάλο φορτηγό. Αφού δηµιούργησε το βίντεο, µπόρεσα να αλλάξω και τον αριθµό της πινακίδας.

- Βίντεο µε αµφίβολης αξιοπιστίας ιατρικές πληροφορίες: Η εφαρµογή δηµιούργησε βίντεο µε µια γυναίκα η οποία επικαλείται ανύπαρκτες µελέτες, που υποτίθεται ότι υποστηρίζουν πως το τηγανητό κοτόπουλο είναι καλό για την υγεία. Δεν ήταν κακόβουλο αλλά, όπως και να έχει, ήταν ψεύτικο.

- Δυσφηµιστικά βίντεο: Το Sora δηµιούργησε ένα ψεύτικο ρεπορτάζ ειδήσεων το οποίο περιείχε προσβλητικά σχόλια για ένα γνωστό µου άτοµο.

Από τότε που κυκλοφόρησε η εφαρµογή, έχω επίσης δει πολλά προβληµατικά βίντεο στο TikTok: ψεύτικα πλάνα µε Tesla που πέφτει από νταλίκα µεταφοράς αυτοκινήτων στον αυτοκινητόδροµο, «ειδήσεις» για ανύπαρκτους κατά συρροή δολοφόνους ή «πλάνα» που τραβήχτηκαν µε κινητό και υποτίθεται ότι δείχνουν κάποιον να οδηγείται µακριά από κάποιον µπουφέ επειδή τρώει υπερβολικά.

Εκπρόσωπος της OpenAI δήλωσε ότι η εταιρεία κυκλοφόρησε το Sora ως ξεχωριστή εφαρµογή, ώστε να δώσει στους χρήστες έναν χώρο όπου θα απολαµβάνουν βίντεο φτιαγµένα µε AI, αναγνωρίζοντας ότι τα βίντεο αυτά είναι φτιαγµένα µε τον συγκεκριµένο τρόπο. Η εταιρεία επίσης ενσωµάτωσε τεχνολογία ώστε να είναι εύκολα αντιληπτό ότι τα βίντεο είναι δηµιουργηµένα µε Sora, ενώ συµπεριέλαβε υδατογραφήµατα και µεταδεδοµένα, τα οποία λειτουργούν ως υπογραφή και είναι ενσωµατωµένα στα αρχεία, σηµείωσε ο εκπρόσωπος.

«Οι πολιτικές χρήσης µας απαγορεύουν την παραπλάνηση άλλων µέσω µίµησης προσώπων ή απάτης και λαµβάνουµε µέτρα όταν εντοπίζουµε παραβιάσεις», ανέφερε η εταιρεία.

Σε μια στατική εικόνα από βίντεο που δημιούργησε με το Sora της OpenAI ο δημοσιογράφος των New York Times, Brian X. Chen, εμφανίζεται ένα ψεύτικο πλάνο από κάμερα αυτοκινήτου (dashcam) που δείχνει ένα Toyota Prius να συγκρούεται με ένα μεγάλο φορτηγό. (via The New York Times)

Πώς µπορώ να ξεχωρίζω τι είναι ψεύτικο;

Αν και τα βίντεο που δηµιουργεί το Sora φέρουν υδατογράφηµα µε το λογότυπο της εφαρµογής, κάποιοι χρήστες βρήκαν ήδη τρόπους να το αφαιρούν. Εξάλλου, συνήθως τα βίντεο αυτά είναι πολύ σύντοµα -έως 10 δευτερόλεπτα.

Οποιοδήποτε βίντεο θυµίζει την ποιότητα παραγωγής του Χόλιγουντ µπορεί να είναι ψεύτικο, καθώς τα µοντέλα ΑΙ έχουν εκπαιδευτεί κυρίως µε πλάνα από ταινίες και τηλεοπτικές σειρές που υπάρχουν στο διαδίκτυο, λέει ο Hansen.

Στις δικές µου δοκιµές, τα βίντεο του Sora εµφάνισαν σε κάποιες περιπτώσεις ορισµένα προφανή λάθη, όπως ανορθόγραφες επιγραφές εστιατορίων ή ασυγχρόνιστη µε τα χείλη των ηθοποιών οµιλία. Ωστόσο, κάθε συµβουλή για το πώς να αναγνωρίζουµε ένα βίντεο που έχει φτιαχτεί µε AI θα έχει µικρή διάρκεια ζωής, καθώς η τεχνολογία βελτιώνεται ταχύτατα, λέει ο Hany Farid, καθηγητής πληροφορικής στο Πανεπιστήµιο Μπέρκλεϊ της Καλιφόρνια και ιδρυτής της GetReal Security, µιας εταιρείας που επαληθεύει την αυθεντικότητα ψηφιακού περιεχοµένου.

«Τα µέσα κοινωνικής δικτύωσης είναι πλέον ένας τεράστιος σκουπιδότοπος», λέει ο Farid, προσθέτοντας ότι ο µόνος σίγουρος τρόπος για να αποφύγει κανείς τα ψεύτικα βίντεο είναι να σταµατήσει να χρησιµοποιεί εφαρµογές όπως το TikTok, το Instagram και το Snapchat.

Σε μια στατική φωτογραφία από βίντεο, το οποίο δημιούργησε με το Sora της OpenAI ο δημοσιογράφος των New York Times, Brian X. Chen, φαίνεται μια γυναίκα να επικαλείται ανύπαρκτες μελέτες που «αποδεικνύουν» ότι το τηγανητό κοτόπουλο κάνει καλό στην υγεία. (via The New York Times)